Commençons par rappeler une évidence : la pollution atmosphérique tue. L’OMS indique que 7 millions de morts sont dus à la pollution atmosphérique chaque année dans le monde, principalement via des pathologies respiratoires et cardiovasculaires. L’air que nous respirons est-il toxique ? La réponse est oui.

Lire aussi… Pollution de l’air : Nice encore en retard, d’après une étude

Lire aussi… À Nice, la pollution de l’air coûterait… 383,4 millions d’euros tous les ans

Or, les citadins sont les plus exposés à ce risque de surmortalité, lié aux concentrations élevées que les polluants gazeux et particulaires peuvent atteindre. Les populations urbaines subissent, en effet, non seulement les pollutions issues de sources d’émission locales (transports urbains et chauffage principalement), mais aussi les pollutions diffuses transportées par les courants aériens sur de longues distances (émissions industrielles, pesticides, pollens, aérosols divers).

En France, plusieurs métropoles dépassent régulièrement les seuils réglementaires. L’État français a été condamné à plusieurs reprises pour « action insuffisante » par la Cour de Justice de l’Union européenne (CJUE), et un procès est en cours à Londres sur le rôle de la pollution dans le décès d’un enfant. Pourtant, nous ne partons pas de zéro, loin de là.

Des stations de référence aux microcapteurs

Depuis les années 1970, un vaste réseau de surveillance et de prévision de la qualité de l’air a été progressivement déployé sur l’ensemble du territoire national. Il s’appuie sur un parc de stations dites « de référence » et est géré à l’échelle de chaque région par des structures dédiées, les associations agréées de surveillance de la qualité de l’air.

Les points de mesure sont peu nombreux, mais les instruments sont implantés dans des zones soigneusement choisies et les capteurs utilisés sont rigoureusement étalonnés et exploités. Les associations de surveillance utilisent également des modèles numériques ou statistiques pour estimer la répartition des principaux polluants dans la région considérée.

Cependant, si la rue dans laquelle vous habitez ne dispose pas d’une station de mesure, ce qui a de grandes chances d’être le cas, l’estimation fournie ne correspond en fait qu’à la moyenne statistique du quartier, elle-même élaborée à partir d’un inventaire des sources fixes et du trafic moyen horaire, en tenant compte de la météorologie du jour, le vent surtout.

Autrement dit, si vous cherchez à connaître votre exposition personnelle à la pollution de l’air à partir du dispositif de surveillance national, vous n’obtiendrez dans le meilleur des cas qu’une valeur moyenne, pour un polluant donné. Difficile d’en déduire une information fiable sur votre exposition personnelle à la « pollution de l’air » et encore moins au risque sanitaire que cette exposition représente pour vous.

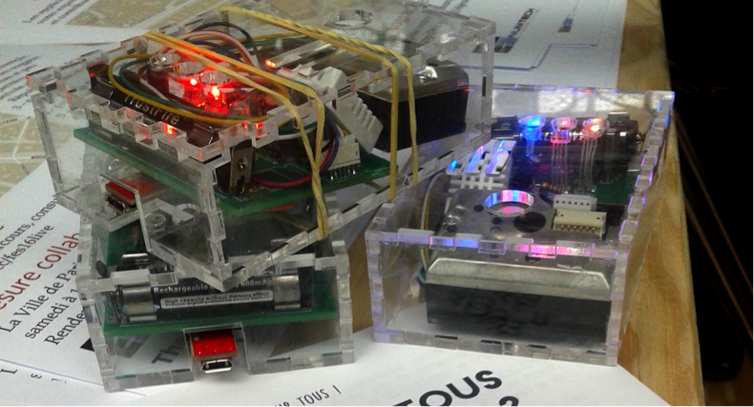

Or, depuis quelques années, on observe l’arrivée sur le marché de « microcapteurs » qui portent avec eux la promesse d’une mesure précise et fiable de son exposition individuelle à la pollution de l’air. Ces instruments de mesure de petite taille et que l’on porte avec soi, accessibles au prix d’un smartphone, pourraient-ils changer la donne ?

Des limites à la conception, à la mesure et à l’utilisation

Un capteur se compose d’un système de détection pour un ou plusieurs polluants, par exemple une diode laser dont le faisceau est atténué ou diffusé par le passage des particules polluantes ; d’un système électronique pour enregistrer le signal ; d’un micro-ordinateur pour l’interpréter (par exemple, convertir l’atténuation du faisceau lumineux durant un temps donné en nombre de particules). Il collecte souvent aussi l’heure, la position, la température et l’humidité.

Dans le cas des stations de référence, la « mesure » d’un polluant est un processus complexe qui nécessite de nombreux tests de qualification en amont ainsi qu’une maintenance coûteuse tout au long de sa durée de vie. Pour garantir la fiabilité des données générées, le capteur doit respecter des conditions d’usage particulières et doit être stationnaire le temps de la mesure notamment. Enfin, pour comparer les données de plusieurs capteurs, les conditions de mesures doivent être similaires : hauteur au-dessus du sol, entrée de l’air dans les capteurs, durée d’intégration des mesures primaires, entre autres.

Les microcapteurs individuels répondent à un cahier des charges différent : ils exploitent des détecteurs de moindre qualité, ils ne sont pas étalonnés régulièrement et ils fournissent des informations souvent intégrées sur une minute au moins pour avoir une précision acceptable. Leur usage est à chaque fois particulier : le capteur peut être en mouvement ou accroché différemment chaque jour par exemple.

Plus problématique encore, pour un modèle donné, chaque capteur se comporte différemment et il n’existe pas encore de stratégie d’étalonnage unique. De plus, tous les instruments sont sujets au phénomène de « dérive de la mesure », qui peut intervenir à des moments différents pour chaque capteur. Dans le cas des microcapteurs, il semblerait selon nos études que la dérive intervienne beaucoup plus rapidement que pour les instruments homologués pour différentes raisons, notamment la robustesse des principes de détection, la miniaturisation des composants de détection, la protection vis-à-vis de perturbations environnementales (température, humidité).

Enfin, l’utilisation de ces microcapteurs par des personnes non formées à leurs usages introduit une source d’erreur supplémentaire : la mauvaise manipulation, par exemple capteur dans la poche ou masqué par une écharpe.

Lorsque l’on fait l’acquisition d’un microcapteur pour son usage personnel, il est donc important de garder à l’esprit que l’on utilise un instrument qui, de facto, ne respecte pas les mêmes standards de qualité que les stations de référence.

Des limites à l’exploitation des mesures

Pour permettre un suivi fiable de sa propre exposition, il est nécessaire de contrôler la qualité des données du capteur. L’approche la plus courante consiste à demander aux porteurs de capteurs mobiles de se rendre périodiquement près d’une station de mesure fixe ou bien de comparer systématiquement les mesures des différents capteurs lorsqu’ils sont à proximité les uns des autres, pour effectuer un inter-étalonnage.

Une autre difficulté vient du fait que la détection d’un pic d’exposition extrême par le capteur mobile est souvent difficile à caractériser : s’agit-il du toast qui a brûlé dans le grille-pain ? Du camion à l’arrêt moteur allumé depuis 10 minutes ? En ayant connaissance de ces éléments contextuels et en les documentant sous la forme de métadonnées, il est possible d’éliminer les faux positifs a posteriori, mais cela implique une attention accrue et un travail supplémentaire au moment de la collecte. Le traitement des données représente donc un défi en soi. On peut y répondre en partie grâce à d’un protocole rigoureux, mais il faut y sensibiliser les usagers de microcapteurs.

Impliquer les individus dans l’estimation de leur exposition

Si, comme on l’a relevé, la plupart des difficultés rencontrées sont de nature technique, les solutions à ces mêmes problèmes pourraient bien reposer en partie sur un recentrage des dispositifs vers l’humain, en particulier à travers des « sciences citoyennes » ou « sciences participatives ».

Former les usagers à l’utilisation de leur instrument et les associer à la co-construction de connaissances est en effet triplement vertueux : une telle démarche représente à la fois un intérêt sociétal (implication citoyenne, développement de la culture scientifique), un intérêt industriel (feed-back utilisateurs, mise à l’épreuve des instruments dans un contexte scientifique), et bien sûr un intérêt scientifique, car cela permet d’augmentation le volume et la représentativité des données et la sécurisation de la qualité de données : les données générées deviennent plus exploitables et plus utiles pour tous.

Cet article a été co-écrit par Jérémy Hornung, de l’association PartiCitEnv’s (anciennement PartiCitaE).![]()

Laurence Eymard, Directrice de recherche CNRS émérite, chercheuse dans le domaine du climat, Sorbonne Université ; Laure Turcati, Ingénieure de recherche en sciences participatives, Sorbonne Université et Sébastien Payan, Professeur, Sorbonne Université

Cet article est republié à partir de The Conversation sous licence Creative Commons. Lire l’article original.